La sfida degli altoparlanti intelligenti, e al contempo degli assistenti digitali, se la stanno giocando Amazon e Google, rispettivamente con i propri device Amazon Echo con Alexa e Google Home con Google Assistente. Quale dei due assistenti è pero’ il migliore, ad oggi? Per il secondo anno consecutivo, uno studio della società di marketing digitale Stone Temple ha trovato l’assistente digitale di Google essere più intelligente dell’assistente Alexa di Amazon. Andiamo a scoprire i punti salienti di questo studio.

Gli assistenti digitali sono importanti e decretano inevitabilmente il successo o meno di un altoparlante intelligente domestico poichè sono il centro dell’esperienza smart che offrono: è tramite il digital assistant che gli utenti ricevono risposte alle domande che pongono e possono impartire dei comandi per gestire i dispositivi connessi che hanno in casa (come accendere le luce, visualizzare un film su Netflix, vedere una telecamera sullo smart display e cosi’ via). Se un assistente digitale funziona male, ad esempio non comprendendo bene i comandi oppure avendo un supporto limitato con i dispositivi connessi in casa, gli utenti preferiscono passare ad altro.

Dall’aggiornamento del 2018 (al 24 aprile) dello studio condotto dalla società di marketing digitale Stone Temple per misurare l’accuratezza nel rispondere a domande informative degli assistenti digitali personali principali, effettuato testando 4.942 domande su cinque diversi dispositivi (Alexa di Amazon, Cortana di Microsoft Invoke, Assistente Google su Google Home, Assistente Google su uno smartphone, Siri di Apple), si è confermato il migliore l’Assistente di Google ma per gli altri assistenti ci sono stati miglioramenti rispetto ai risultati del test condotto lo scorso anno, che è stato pubblicato il 27 aprile 2017 e condotto sugli stessi dispositivi eccetto che per l’Assistente Google su smartphone.

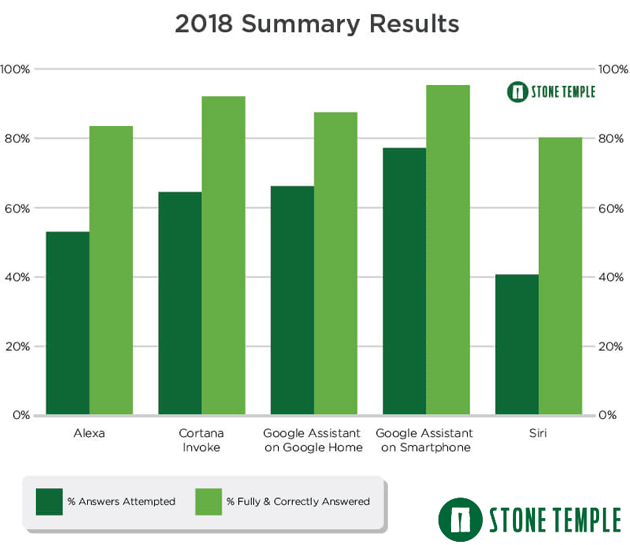

Risultati sommari del 2018 dello studio

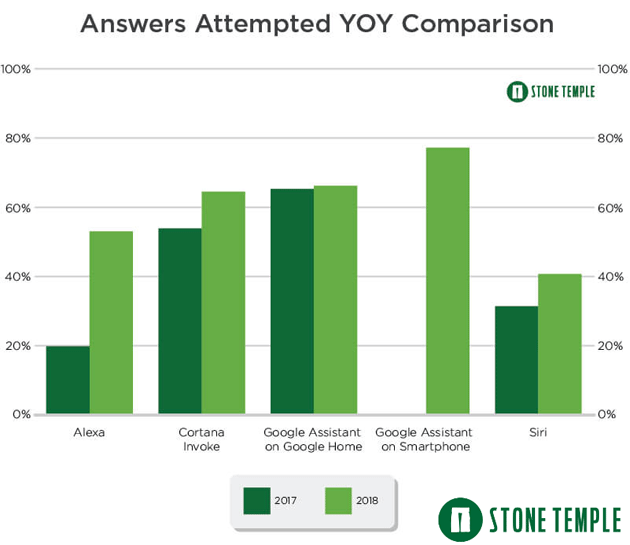

Lo Studio ha tenuto conto delle Risposte Tentate, vale a dire che l’assistente personale ha pensato di comprendere la domanda e fatto uno sforzo esplicito per fornire una risposta. Non sono inclusi i risultati in cui la risposta era "Sto ancora imparando" o "Mi dispiace, non lo so", o le risposte in cui è stata tentata una risposta ma la query è stata ascoltata in modo errato (quest’ultimo caso è stato classificato separatamente indicando una limitazione nelle abilità linguistiche, non della conoscenza). Nello studio condotto nel 2018, rispetto al precedente anno, tutti e quattro gli assistenti personali hanno aumentato il numero di risposte tentate ma il cambiamento più importante è stato notato in Alexa di Amazon, con un aumento di queste risposte passato dal 19,8% al 53,0%. Cortana di Microsoft su Invoke ha visto il secondo aumento maggiore nelle risposte tentate – dal 53,9% al 64,5% – seguito da Siri di Apple – dal 31,4% al 40,7%.

Comparazione di Risposte Tentate 2017 vs 2018

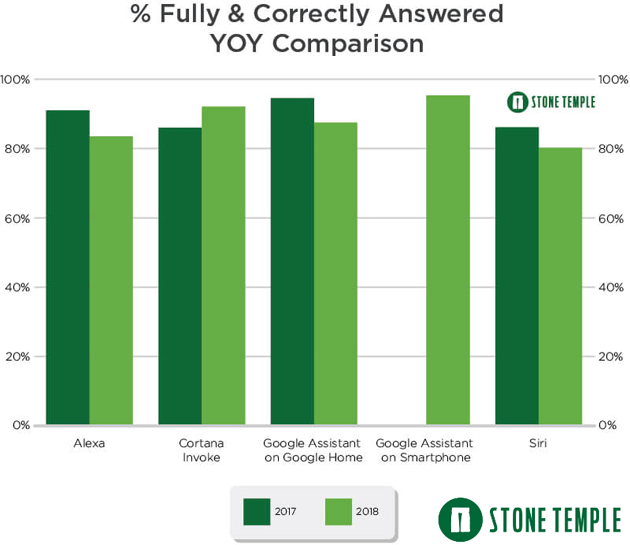

Nello Studio si è tenuto conto anche delle risposte "Complete e Corrette", vale a dire che all’esatta domanda posta è stata fornita una risposta "completa e corretta" – ad esempio, se è stato chiesto all’assistente personale quanti anni ha Abraham Lincoln ma la risposta è stata la sua data di nascita questa non è stata considerata una risposta "completa e corretta". Nello studio condotto nel 2018, rispetto al precedente anno, il solo assistente che ha aumentato la precisione è stato Cortana – dall’86,0% al 92,1% – mentre Alexa ha diminuito il suo livello di risposte complete e corrette ma, considerando l’aumento importante di risposte tentate di 2,7 volte, questo calo è da considerarsi comunque accettabile.

Non è insolito ricevere risposte che non sono completamente corrette: una query potrebbe avere più risposte possibili, ad esempio "quanto velocemente va un giaguaro?" dove "giaguaro" puo’ riferirsi ad un animale, un’auto o un tipo di chitarra. In questi casi, anzichè ignorare la query l’assistente personale può scegliere di chiedere informazioni aggiuntive all’utente per meglio inquadrare il soggetto della frase oppure puo’ fornire una risposta parziale corretta, oppure ancora potrebbe dare una risposta sbagliata.

Comparazione di Risposte Complete e Corrette 2017 vs 2018

In conclusione, ecco alcune osservazioni sommarie dall’aggiornamento 2018 dello studio di Stone Temple:

– Google Assistant risponde ancora alla maggior parte delle domande e ha la percentuale più alta a cui viene data una risposta completa e corretta.

– Cortana di Microsoft ha la seconda più alta percentuale di domande risposte complete e corrette.

– Alexa ha ottenuto i maggiori miglioramenti in un anno, rispondendo a 2.7 volte più domande rispetto allo studio dell’anno precedente.

– Ogni assistente personale in competizione ha compiuto progressi significativi nel colmare il divario con Google.